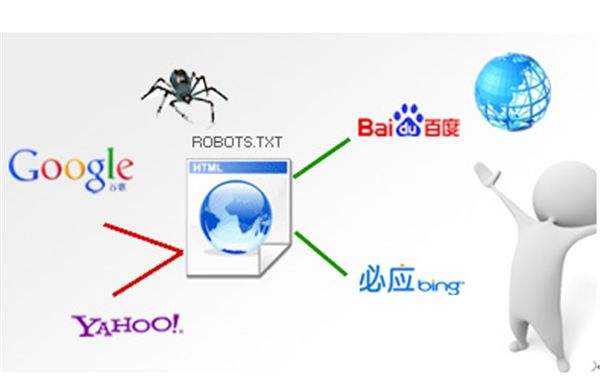

robot(又称spider)是搜索引擎通用的一种程序,自动访问互联网上的网页并获取网页信息。规范robots.txt其实是网站SEO优化的很重要的一点。

以wordpress为例,一些地址是不应该被搜索引擎索引的,比如后台程序、FEED地址等,一个针对WordPress的robots.txt的实例如下:

User-agent: *

Disallow: /wp-

Disallow: /trackback/

Disallow: /feed/

Disallow: /comments/feed

给出一个简单例子网友就很容易理解robots.txt的写法,这应该比看百度的搜索引擎帮助要容易的多。

(1)禁止搜索引荐抓取子目录

以godaddy的150G虚拟主机为例,可能在网站下还有别的目录绑定了另外的域名,不过搜索引荐有时候确自做聪明将别的站的内容以www.iewb.net/aaa这样的形式抓取了过来,这可以通过robots.txt来解决:

User-agent: *

Disallow: /aaa/

Disallow: /bbb/

(2)禁止搜索引荐抓取图片

如果网站图片被百度“盗链”,那你的流量消耗会特别快,google还好一些,点击图片的时候会进入你的网站,给你导入一些IP,百度则是赤裸裸的盗链。如果你不想搜索引荐抓取你网站的图片,可以这样写robots.txt解决:

User-agent: *

Disallow: /*.jpg$

Disallow: /*.jpeg$

Disallow: /*.gif$

Disallow: /*.png$

Disallow: /*.bmp$

(3)使用"*"限制访问url

禁止访问/aaa/目录下的所有以".htm"为后缀的URL(包含子目录)。

User-agent: *

Disallow: /aaa/*.htm

(4)使用"$"限制访问url

仅允许访问以".htm"为后缀的URL。

User-agent: *

Allow: .htm$

Disallow: /

过多的搜索引擎爬虫会带来很大的服务器负载,通过robots.txt禁止抓取部分目录可以一定程度降低服务器负载。网站内大量不同链接指向相同的内容时,搜索引擎可能会认为网站质量低下,正确使用robots.txt可以减少重复收录,提高网站独特性。

最后提醒新手一点robots.txt要上传到网站根目录。

Proudly Powered By WordPress | IEWB.NET 2009-2024 版权所有